Confusion matrix

Training을 통한 Prediction 성능을 측정하기 위해 예측 값과 실제 값을 비교하기 위한 표

정확도 (Accuracy) = TP + TN / Total

- 모두 맞은 레이블(1을 1로, 0을 0으로)를 전체로 나눈 값입니다.

- 종속변수(Target)의 비율이 불균형한 경우는 주의해야한다.

정밀도(Precision) = TP / TP + FP

- Positive로 예측한 것 중에, 실제 Positive를 맞춘 비율

재현율(Recall, Sensitivity) = TP / TP + FN

- 실제 Positive인 것중에 Positive로 예측한 비율

F1-Score

- 정밀도와 재현율의 조화평균 값,

- 정밀도와 재현율이 어느 한쪽으로 치우치지 않는 수치를 나타낼 때 상대적으로 높은 값을 가짐

위양성률( Fall- out ) = FPR (False Positive Rate)*

- 실제 양성 클래스(Negative)에 표본 중에 음성 클래스에 속한다고 예측한 비율

- FP / FP + TN

임계값(threshold)

- 0과 1에 대한 예측 확률이 있을 때 , 기준 값을 정해서 0.5인 경우 50%이상 1이면 해당 데이터는 1로 분류합니다.

- 임계값을 낮추면, 재현율은 오르고, 정밀도는 떨어집니다.

- 적절한 임계값 설정을 통해, 좋은 모델을 구성할 수 있습니다 그러기 위해 등장한 것이 AUC, ROC의 개념입니다.

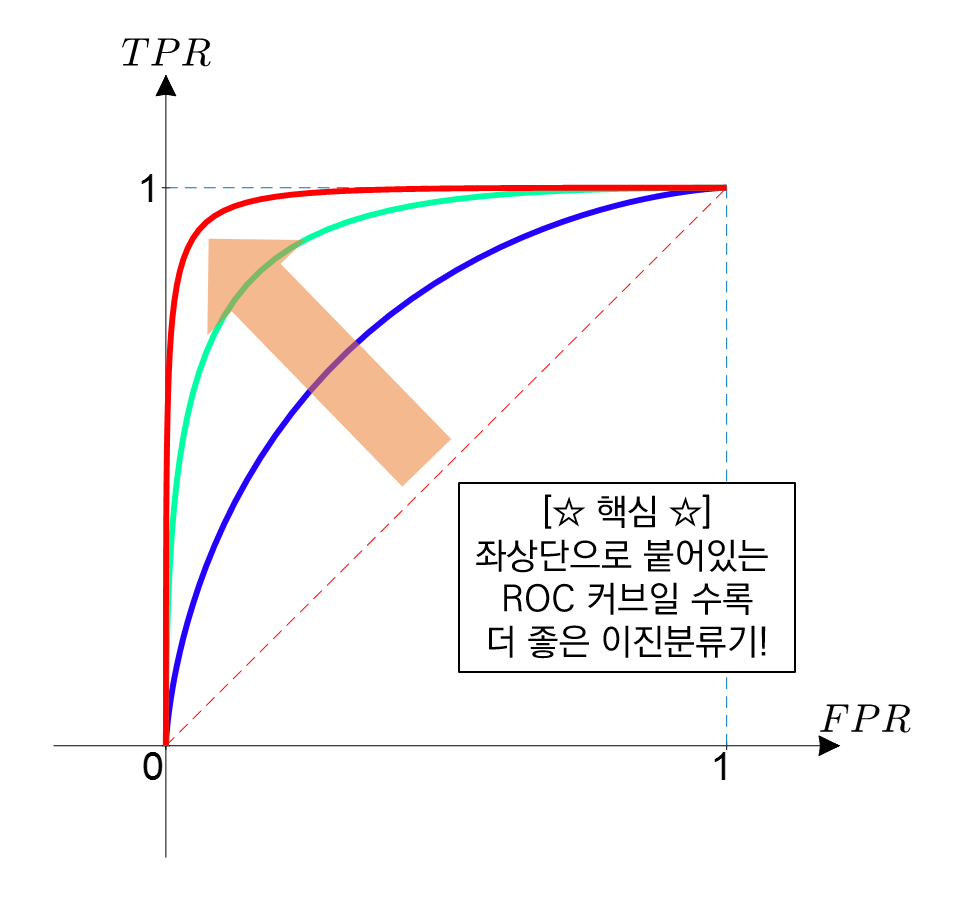

ROC, AUC (Receiver Operationg Characteristic, Area Under the Curve)

ROC는 여러 임계값에 대해 TPR(True Positive Rate, recall)과 FPR(False Positive Rate) 그래프를 나타냅니다.

- 재현율은 최대화하고, 위양성률은 최소화 하는 임계값이 최적의 값입니다.

- AUC는 ROC curve의 아래 면적입니다.

정밀도, 재현율, 임계값 정확도의 관계

- 정밀도 - 재현율 : 반비례

- 임계값 - 정밀도 : 비례

- 재현율 - 임계값 : 반비례

'머신러닝' 카테고리의 다른 글

| 의사결정트리, 랜덤포레스트, 분류모델평가기법, 모델선택 복습 (0) | 2021.08.13 |

|---|---|

| 모델 선택( Model Selection ) (0) | 2021.08.12 |

| 랜덤포레스트( Random Forest ) (0) | 2021.08.10 |

| 의사결정트리( Decision Tree ) (0) | 2021.08.09 |

| 회귀모델 및 모델 평가 방법 등 복습 (0) | 2021.08.06 |